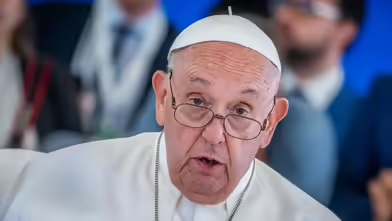

DOMRADIO.DE: Die New York Times berichtete vor kurzem, dass Angriffsdrohnen in der Ukraine bereits teilautonom agieren, sie seien in der Daten- und Mustererkennung schon weit. Es scheint zumindest technisch nur noch ein kleiner Schritt zu vollautonomen Waffen. Und Papst Franziskus hat beim G 7-Gipfel im Juni jüngst gefordert, den Einsatz von autonomen Waffen zu verbieten. Die Forderung nach einer Kontrolle von KI und Waffensystemen klingt gut. Aber wie realistisch ist denn eine tatsächlich wirksame Kontrolle?

Dr. Anton Losinger (Weihbischof im Bistum Augsburg und stellvertretender Vorsitzender der Kommission für gesellschaftliche und soziale Fragen der Deutschen Bischofskonferenz sowie ehemaliges Mitglied im Deutschen Ethikrat): Eine realistische und wirksame Kontrolle von Waffentechniken, die KI-unterstützt sind, ist schlichtweg unvermeidlich. Würden wir als logisch denkende Menschen diese Chance der Waffenkontrolle im KI-Bereich nicht ergreifen, wären wir buchstäblich nicht mehr zu retten.

Denn das sagt auch der Papst bei seiner Teilnahme bei dem G7-Treffen in Süditalien: Künstliche Intelligenz ist eine neue qualitative Stufe der technischen und wissenschaftlichen Entwicklung. Künstliche Intelligenz hat immer zwei Seiten. Die Wissenschaft sagt: "Dual Use", einerseits mit dramatischen Fortschrittsmöglichkeiten in der Förderung menschlicher Möglichkeiten, aber auf der anderen Seite auch ein ungeheures Zerstörungspotenzial.

Deshalb ist es klar und das ist auch klar die Option des Papstes: Da, wo solche Technologien in Gang gesetzt werden, müssen sie kontrolliert werden. Nicht zuletzt die Europäische Union mit ihrem AI-Act (Eine europäische Verordnung über künstliche Intelligenz, die erste umfassende Verordnung über KI durch eine Regulierungsbehörde weltweit, Anm. d. Red.) hat das vorgemacht.

DOMRADIO.DE: Wie kann dann die Kontrolle zum Beispiel weltweit aussehen?

Losinger: Es ist so wie bei den Menschenrechten. Die Menschenrechte haben weltweite Geltung, das sagen wir immer. Und Menschenrechtsverächter werden weltweit verfolgt. Der Weg dorthin ist lang und steinig, wenn man alle denkbaren Verbrecher vor Augen hat.

Aber es führt nichts daran vorbei, dass das Ziel der unbedingten Achtung der Würde und der Rechte des Menschen aufrecht erhalten bleiben muss. Eine Menschheit, die hier aufgibt - aus welchen Gründen auch immer - würde sich selbst aufgeben.

DOMRADIO.DE: Gerade in der Ukraine wird die Entwicklung vorangetrieben. Das Land steht aber auch unter ständigem Beschuss durch Russland. Wenn die Technik da ist und der Ukraine helfen kann, dann könnte man auch sagen, warum man sie dann nicht auch einsetzen sollte?

Losinger: Die Ukraine und die Gegenseite leben uns derzeit vor, was es bedeutet, wenn autonome Waffentechnologien aufeinander losgehen können, wenn sehr günstig herstellbare, sehr billige und auch sehr intelligente Waffensysteme sowohl in der Zerstörung als auch in der Bedrohung des Gegners bisher gekannte Grenzen überschreiten.

Die Problematik, die uns mit Künstlicher Intelligenz hier begegnet, ist eine, die die NATO schon längst betrifft. Wir haben immer die Frage gehabt, ob Maschinen töten dürfen. Der Papst sagt strikt und klar: Nein, weil Maschinen niemals verantwortliche Wesen sind und Verantwortung übernehmen können.

Aber wenn wir wollen, dass Maschinen nicht töten, dann ist zunächst einmal die Restriktion der NATO bei autonomen Waffensystemen sinnvoll. Also zu sagen, ehe ein Tötungs- oder Verletzungsbefehl umgesetzt wird, muss zunächst ein Mensch seine Zustimmung geben.

Aber das Weitere, darüber Hinausgehende ist: Wie wird ein künftiger Krieg aussehen, wenn wir lernende Algorithmen, sich ständig selbst optimierende Kriegstechnologien immer weiterentwickeln? Wie weit ist der Abstand bis zum totalen Krieg?

Und hier mein ganz klares, starkes Votum: Das eigentliche Problem ist nicht die KI-Technologie. Das eigentliche Problem ist die Politik und es ist die Frage menschlicher Verantwortungsübernahme über Konflikte im Krieg und in militärischen Auseinandersetzungen.

DOMRADIO.DE: Und doch ist das Problem von autonomen Waffen oder Waffen, die sich stark in diese Richtung entwickeln, sehr konkret. Die Ukraine wird konkret bedroht. Wenn man jetzt sagen würde, dass die Ukraine darauf verzichtet den Bereich der autonomen Waffen weiterzuentwickeln, den Krieg verlieren würde und der Gegner dann diese Technik bekommen würde, was wäre dann aus ethischer Sicht gewonnen?

Losinger: Es ist verständlich, dass zunächst einmal ein Land, das in der Situation ist, sich verteidigen zu müssen und die eigenen Bürger zu schützen, ein Recht dazu hat. Die kirchliche Sozialethik sagt: Dieses Recht ist legitim, aber es muss verhältnismäßig sein. Das heißt, es darf keine unvergleichlich höhere Zerstörung stattfinden als die Verteidigung selber einnimmt.

An diesem Punkt darf ich als wissenschaftlich Interessierter gerne ein Opus einführen. Ich spreche von einem der klugen Professoren an der Universität Freiburg, Jörn Leonhard. Sein berühmtes Buch trägt den Titel "Über Kriege und wie man sie beendet. Zehn Thesen." Es wurde übrigens gerade letztes Jahr mit dem hoch angesehenen Leibnizpreis ausgezeichnet.

Seine strenge These, die vielleicht enttäuschend klingen mag, lautet: Große Auseinandersetzungen und Kriege enden eigentlich nur mit der Erschöpfung der Ressourcen. Solange einer der beiden Gegner noch Chancen sieht, den anderen niederzuringen, ehe die eigenen Ressourcen verbraucht sind, sagt er, werden Kriege nicht enden. Deshalb ist eine solche Situation entstanden, bei der dringend politisches Handeln erforderlich ist und damit auch eine grenzenlose Verletzung von Menschenrechten ausgeschlossen werden kann.

Ich persönlich habe auch im Anschluss an die sehr kluge Rede des Papstes bei der G7-Konferenz in Apulien drei strikte Kriterien überlegt, die in dieser Situation angewendet werden sollten. Ich sage erstens: Bei sämtlichen Anwendungsfällen Künstlicher Intelligenz und den Auswirkungen davon muss es immer ein klares Technikfolgenabschätzung-Szenario geben. Wir dürfen nicht Technologien in Gang setzen, über deren Ende wir nicht nachgedacht haben.

Zweitens meine ich, dass wir immer eine menschenrechts- und menschenwürdekonforme Technologie brauchen. Wo Technologien in Gang gesetzt werden, welche Menschenrechte im Grundansatz vernichten oder auslöschen, kann eine solche Technologie nicht in Gang gesetzt werden. Zum Beispiel gibt es eine ganze Reihe von chemischen und biologischen Themenfeldern, bei denen die Menschenwürde verachtende Praktiken möglich sind.

Und schließlich drittens geht es um die Gesellschaft. Ich meine, dass die soziale Kompatibilität aller künstlich intelligenten Verfahren geprüft werden muss. Zum Beispiel: Was ist, als Negativszenario, wenn technische Überwachungsszenarien mit Akustik und Optik wie etwa in China dabei sind, eine gesamte Gesellschaft zu überwachen und zu kontrollieren? Hier muss darüber nachgedacht werden, wie soziale Kompatibilität gewährleistet werden kann und eine Gesellschaft in ihren Rechten nicht von innen her aufgelöst werden kann.

DOMRADIO.DE: Wenn die KI nun aber in der Lage wäre zu erkennen, ob es sich um militärische Ziele oder zivile Ziele handelt, wäre es dann nicht auch ein Argument für die KI, die sich strikter an militärische Ziele ausrichtet, als das der Mensch bisweilen tut?

Losinger: Der Papst hat in seiner Rede in Apulien am 14. Juni vor der G7-Konferenz beide Seiten der KI betont und auch wörtlich gesagt: "Es handelt sich um das Aufkommen einer Künstlichen Intelligenz, die wahrhaft eine kognitive industrielle Revolution bedeutet, mit all den Möglichkeiten."

Aber er spricht davon, dass es eine faszinierende und zugleich unheimliche Dimension ist, die dieses Instrument betrifft. Und das ist ihm vor allem angesichts der mächtigsten Vertreter dieser G7-Konferenz im Blick auf die Waffen sehr deutlich in die Feder geflossen, wenn er sagt: "Wir müssen menschliche Kontrolle über Programme Künstlicher Intelligenz wahren, die sie garantieren und schützen, wo es um die menschliche Würde selbst geht und wo diese auf dem Spiel steht. Das gilt vor allem über den Gebrauch der sogenannten tödlichen autonomen Waffen."

Und sein Schlusssatz: "Keine Maschine darf jemals die Wahl treffen können, einem Menschen das Leben zu nehmen." Das ist die technisch-ethische Perspektive, die natürlich jetzt auf die Notsituation eines laufenden Krieges umgesetzt werden muss.

Wir wissen um die Notwendigkeit, Menschen in ihren Rechten zu verteidigen. Wir müssen sehen, dass verhindert werden muss, dass Kinder und nicht-wehrfähige Leute verletzt werden. Aber wir müssen im Hinterkopf haben, dass Kriege beendet werden und am besten nicht am Zeitpunkt der Erschöpfung.

Das Interview führte Mathias Peter.